Nowoczesne technologie pomagają zmienić świat na lepsze, uczenie maszynowe czy sztuczna inteligencja są innowacyjnymi rozwiązaniami, jednak w kwestii dostępności wiele im brakuje do doskonałości.

Opublikowano: 2022-07-31, aktualizacja: 2024-06-26 przez Smyku

Si, a dostępność

Gdy widzę kolejne achy i echy na temat SI oraz jak bardzo ona wpływa na rozwój biznesu, to automatycznie załącza się u mnie hamulec bezpieczeństwa. Oczywiście nowoczesne technologie jak najbardziej pomagają zmienić świat na lepsze, ale uważam, że obecnej SI daleko jest do doskonałości i nadal trzeba ją zastępować człowiekiem, a nie odwrotnie.

Powodem dla którego tak pisze jest fakt, że gdy używam obecnie najnowszych narzędzi, zawartych choćby w smartfonie, Internecie czy pakiecie office, to zawsze wymaga to ode mnie wysiłku by treść, którą umieszczam była dostępna. Bo naturalnie o dostępności będzie mowa.

Alternatywna tekstowa dzięki SI… nie, dziękuję

Pirwszym przykładem sytuacji gdzie SI nie daje sobie rady, są automatycznie generowane transkrypty, napisy do filmów lub spotkań na żywo, a także automatycznie generowane teksty alternatywne dla obrazów, które naprawdę pozostawiają wiele do życzenia.

Oto tekst alternatywny dla obrazu, który został wygenerowany automatycznie przez program Microsoft Power Point w wersji Office 365: „Obraz zawierający osoba, wewnątrz, ściana, kobieta”.

A teraz kolejne jeszcze przyjemniejsze:

„Kobieta odżywia lody”

„Szpalty używające zaczesanych zaczesanych włosów i zaczesanych włosów do przycinania końców włosów mężczyzny”

„Widok z tyłu pięciu kulek na scenie”

„Rośliny do pojenia”

I mój faworyt

„Zdjęcie lotnicze podwładnych z łajdakiem”

Ja rozumiem że, język Polski jest trudnym, no ale bez takich jaj…

Dodatkowo, aby nie być gołosłownym, że algorytmy Ai to lekka technologiczna pomyłka, zapytałem Chat GPT o tekst alternatywny do tego zdjęcia. Oto co mi odpisał:

Obrazek przedstawia widok ogrodu z lotu ptaka, uchwycony za pomocą drona. W centrum zdjęcia widoczny jest prostokątny trawnik otoczony różnorodnymi roślinami i krzewami. Po lewej stronie znajduje się niewielka altana, a obok niej widoczny jest oczko wodne z liliami wodnymi. W prawym dolnym rogu zdjęcia znajduje się ścieżka z kamieni, prowadząca do małego drewnianego mostka. Kolory na zdjęciu są żywe, z dominującą zielenią trawnika i roślinności, kontrastującą z kolorowymi kwiatami.Chciałem się zapytać, któregoś z Was - ludzi, czy ktoś widzi na tym zdjęciu altanę, oczko wodne z liliami oraz ścieżkę z kamieni? I skąd Chat GPT wykminił, że zdjęcie było zrobione dronem? Czatowi GPT mylą też się strony, ową altanę umieścił po lewej stronie zdjęcia, tym czasem wejście do niej tudzież do domu jest po prawej stronie zdjęcia.

Teraz wyobraźcie sobie, że w prezentacji, którą tworzycie umieściliście powiedzmy 30 slajdów i na każdym z nich macie obraz, któremu musicie poprawić tekst alternatywny, bo algorytm SI odpowiedzialny za generowanie tekstów alternatywnych po prostu nie dał sobie z nimi rady.

Czy w takim układzie jest sens stosowania takiego mechanizmu?

Czy nie szybciej i poprawniej będzie jeśli program tylko wymusi na mnie dodanie tekstu alternatywnego, a ja go dodam poprawnie i sensownie?

Na te pytania znam odpowiedź, ale mimo wszystko pozostawiam je do Waszej oceny.

Ok może powiecie, że to tylko sugestia z automatu, a pole jest edycyjne i każdy może sobie je zmienić. Tak, jednak nie każdy to zrobi, bo nie każdy ma świadomość, że należy tam wejść i coś wpisać, a jak nic nie wpisze to ma pod tym kątem niedostępny dokument.

Automatycznie generowane teksty alternatywne to trochę jak wybór mniejszego zła, między całkowitym brakiem dostępności, a jej nieodpowiednim zapewnieniem.

Dostępnościowy bełkot SI

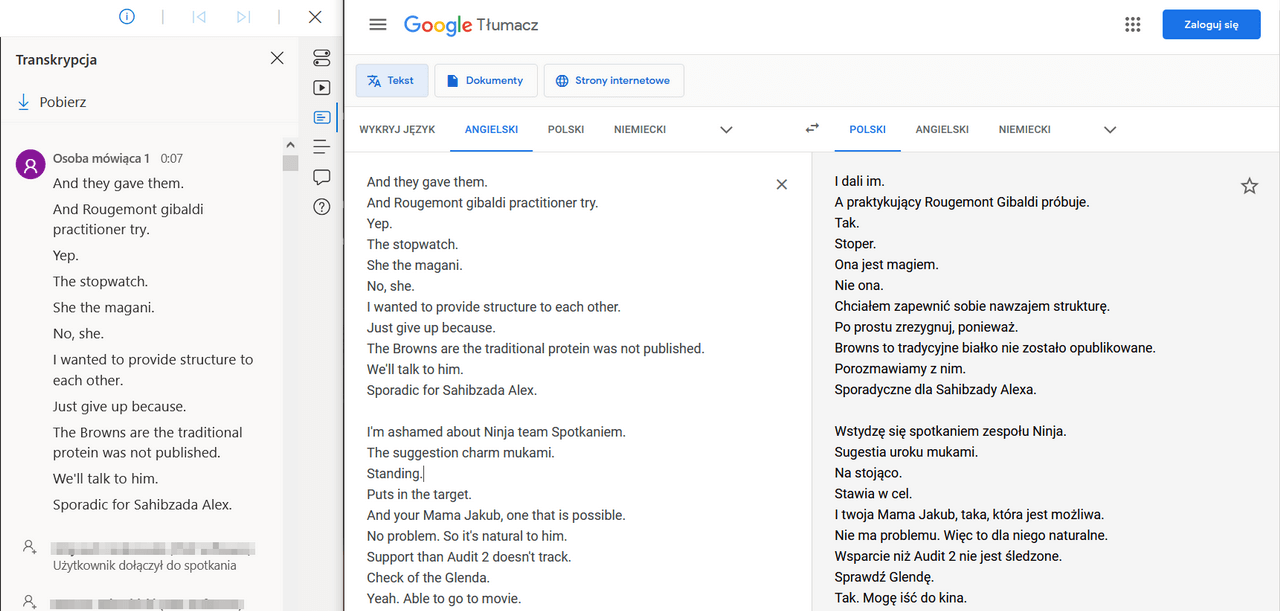

Spokojnie to jeszcze nic. Poniżej przykład 30 sekundowego transkryptu wygenerowanego automatycznie na platformie Microsoft Teams, który został dodany po zakończeniu nagrania jednego z spotkań dotyczących dostępności, w którym miałem przyjemność brać udział. Na nieszczęście mechanizmów tłumaczących spotkanie było prowadzone w języku polskim.

Oto rezultat tłumaczenia po wrzuceniu transkryptu w translator Google (wersja angielska jest równie pojechania jak polska więc nie będę jej załączał):

„I dali im. A praktykujący Rougemont Gibaldi próbuje. Tak. Stoper. Ona jest magiem. Nie ona. Chciałem zapewnić sobie nawzajem strukturę. Po prostu zrezygnuj, ponieważ. Browns to tradycyjne białko nie zostało opublikowane. Porozmawiamy z nim. Sporadyczne dla Sahibzady Alexa. Wstydzę się spotkaniem zespołu Ninja. Sugestia uroku mukami. Na stojąco. Stawia w cel. I twoja Mama Jakub, taka, która jest możliwa. Nie ma problemu. Więc to dla niego naturalne. Wsparcie niż Audit 2 nie jest śledzone. Sprawdź Glendę. Tak. Mogę iść do kina.”

Jest to kompletny bełkot, który w najlepszym przypadku wywoła uśmiech na twarzy czytającego ten tekst.

Ostatecznie stworzenie czytelnego i dostępnego transkryptu z 1,5 godzinnego zapisu spotkania w języku polskim zajęło mi prawie cały dzień roboczy.

SI i brak czynnika ludzkiego

Niestety, tak właśnie działają obecnie algorytmy SI, które budowane są bez uwzględnienia czynnika ludzkiego. Bo gdyby nawet coś działo się z automatu, ale po drodze był człowiek, osoba moderatora, która fizycznie zaakceptuje lub chociaż przejrzy pobieżnie jakość tego transkryptu, to może wtedy nie dostalibyśmy zlepka bzdur, gdyż taki transkrypt został by po prostu przez nią odrzucony. Tymczasem po zakończeniu nagrania platforma Microsoftu sama dorzuca takie kwiatki do nagrań, z którymi nie za wiele da się zrobić poza ich wyłączeniem.

W obu przypadkach czy to poprzez błędny tekst alternatywny, czy też bełkot płynący z transkryptu, treść jest niezgodna z wymaganiami WCAG i jednego z pryncypiów jakim jest postrzegalność.

I znów ktoś powie, że z czasem na pewno to się zmieni, gdyż algorytmy są ulepszane i tłumaczone teksty będą coraz lepszej jakości. Mam nieco mieszane zdanie na ten temat, jak już wspomniałem powyżej, jeśli miałbym przeczytać 30 stronnicowy tekst wygenerowany (tudzież przetłumaczony) automatycznie i później go poprawiać w prawie co każdym zdaniu, to niewiele dłużej zajmie mi jego napisane od początku z logiką zdania i sensownością przekazu.

Automatyczne tłumaczenia generowane przez mechanizmy SI nie są adekwatne dla rzeczywistego przekazu.

I to jest akurat spory problem automatycznych tłumaczeń np. na platformach streamingowych takich jak na YT, Vimeo lub też innych zautomatyzowanych tłumaczeń jak ‘Google translate’.

Świetnie to ukazuje artykuł autorstwa Aylin Dunham1, która udowadnia w nim, że automatyczne wygenerowane napisy w YouTube, są po prostu „do kitu” i nie spełniają przepisów dotyczących dostępności jak choćby amerykańskiej ustawy ADA2 (Americans with Disabillity Act), a zaleceniem jest po prostu ich wyłączenie i dodanie własnych zrobionych w taki sposób tak, aby multimedia były dostępne3. Może gdy wszyscy uświadomimy sobie, że nie warto iść po bandzie (na tak zwaną łatwiznę), to w końcu z social mediów znikną nagrania oznaczone hashtagiem #CaptionFail i im podobne4 5. Niestety odkąd amerykańska ustawa ADA oraz wiele innych pokrewnych aktów prawnych dotyczących dostępności, nakłada obowiązek dodawania napisów do filmów, robione jest to na szybko, byle jak, byle tylko nie zostać od razu pozwanym za niezapewnienie dostępności, pomimo, że nadal nie jest to zgodne z wymogami dostępności.

Przyjrzyjmy się też innemu przykładowi.

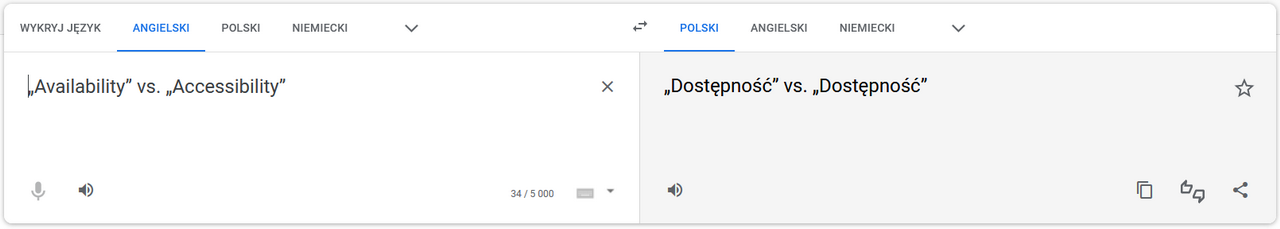

Wpiszmy dwa słowa „Availabillity” i „Accessibility” do translatora Google tłumacząc je na język polski.

Dla tłumacza oba słowa znaczą dostępność, ale w rzeczywistości w języku angielskim te słowa mają dwa różne znaczenia.

Na przykład zdania "product is available" versus "product is accessible".

W pierwszym zdaniu oznajmiamy, że nasz produkt jest dostępny np. fizycznie osiągalny w sklepie lub na magazynie, drugie zdanie bardziej odnosi się do tego czy produkt spełnia wymagania dostępności np. dostępności cyfrowej.

Więc wrzucając coś do rozwiązania program tłumaczącego z polskiego lub innego języka z którym owe oprogramowanie radzi sobie „średnio”, zwróć proszę uwagę czy aby algorytm nie przetłumaczył tego tekstu niepoprawnie. W przeciwnym przypadku treść może być po prostu źle zrozumiana przez użytkownika, co z resztą jest niezgodne z normą WCAG i jego pryncypium zrozumiałości.

Automatycznie generowane napisy do filmów od wielu lat są problemem dostępności

Oto film z 2016 roku autorstwa McMaster Libraries prezentujący, że stosowanie automatycznie wygenerowanych napisów, sprawia nie są one niepoprawne nie tylko pod kątem dostępności. (film w wersji anglojęzycznej)

Transkrypt tego nagrania w języku angielskim

When YouTube Automatic Closed Captioning Goes Wrong

Let’s watch this video clip from the Rick Mercer Report, January 2009.

Let’s stop here. This is all wrong.

YouTube’s automatic closed captioning service doesn’t always, or even often,

produce correct captioning on its own.

As you saw in the video clip sometimes the automatic,

YouTube-produced closed captions are completely incorrect.

Thankfully there’s an easy fix to this problem.

You can edit these automatic captions,

or upload a transcript of the audio to your YouTube video in order to produce accurate closed captions.

The important thing is that when the video says, for example:

“I've just bumped into Dr. Peter George

Hello, Sir!” “Rick. Welcome.”

“You have a Med School here, right?”

The closed captions don’t- as this clip originally did- incorrectly suggest that the speaker said:

“I just pumped into doctor Peter George hello sir welcome ummm school here %uh”

…because that’s just ridiculous.

Caption your videos correctly and make living and learning easier for everyone.

For more information go to accessibility.mcmaster.ca.

Kolejny przykład tym razem z naszego podwórka.

W jednym z filmów na YT dotyczącym rozwiązań do automatycznego generowania napisów do filmów, znalazłem wypowiedź człowieka6, który opowiada o zaletach i wadach jednego z tego typu programów. Przy końcu 2-giej minuty filmu z jego ust padają słowa: ”No i co włazimy na stronę internetową Happy Scribe” jednocześnie w tym samym momencie w napisach znajdujemy w połowie ucięte zdanie: „No i co na stronę internetową”.

Oglądając dalej film trafiamy na różnego rodzaju kwiatki typu - słowa „Happy Scribe”, są tłumaczone jako „Happy sklep”, a słowo „Un-packing” to „anty parking”, natomiast słowa „transkrypcja podkastów” to „transkrypcja pod Case”, a „artykuł z podkastu”, to nic innego jak „artykuł spod kasy”.

No dziękuję YT za pomoc, ale gdybym nie miał słuchawek na uszach, to bym zapewne nie ogarnął o co chodzi, nawet jako osoba w pełni słysząca.

Asystenci głosowi i wykluczenie cyfrowe

Ok. Przejdźmy teraz do technologii (nie)codziennego użytku.

Chyba każdy z nas słyszał i choć raz wypróbował asystenta głosowego. Na rynku takich asystentów jest już kilka. Firma Microsoft wyposażyła Windows w asystenta głosowego Cortana, takiego asystenta o nazwie Siri od dłuższego czasu ma także firma Apple. Google nie chcąc pozostać w tyle także umieściło w Androidzie swojego asystenta. Nawet Amazon wypuścił na rynek wirtualną asystentkę Alexę. Można powiedzieć, że wirtualni i głosowi asystenci rozgościli się w naszej rzeczywistości na dobre. Są to rozwiazania przynajmniej częściowo, jeśli nie w pełni oparte na mechanizmach SI. Z punktu widzenia innowacyjności i użyteczności wszystko fajnie, ale czy takie rozwiązania są dostępne.

Może i są, tylko po warunkiem, że…

- mówisz wyraźnie

- wolno

- nie w języku, którego asystent/ka nie rozpoznaje

Np. nie w języku polskim gdyż takie rozwiązania jak Cortana i Alexa języka polskiego po prostu nie rozumieją. Z naszym ojczystym językiem, trochę lepiej radzi sobie Asystent Google, ale i on też miewa problemy ze zrozumieniem tego co do niego wypowiadamy. Siri także nie radzi sobie z językiem polskim, choć obsługuje 21 innych języków.

Jednak pozostawiając już nasz ojczysty język w spokoju, to żadne z przytaczanych powyżej rozwiązań - nawet gdyby do niej mówić po angielsku - nie da sobie rady, gdy będzie do niej mówiła osoba z wadą wymowy np. jąkająca się lub mająca jakiekolwiek inne schorzenie wpływające na zdolność wyraźnego mówienia. Wtedy takie osoby w ogóle nie są w stanie korzystać z systemów przekształcających mowę na tekst.

Ba! Mi samemu nie raz zdarzyło doświadczyć przegranej asystenta Goolge, który poległ podczas wprowadzania tekstu, tylko gdy chciałem to zrobić szybko lub w tle były jakiekolwiek drobne zakłócenia akustyczne.

Zatem jeśli nie mogę użyć nowoczesnych form komunikacji czy też metody wprowadzania danych jakimi są m.in. asystenci głosowi i to tylko dlatego, że nie mówię po angielsku, mówię szybko lub mam wadę wymowy, to czym to jest jeśli nie wykluczeniem cyfrowym…?

Ograniczenie działania asystentów głosowych tylko do kilku języków/krajów to także trochę dzielenie użytkowników na lepszych i gorszych. No bo niby dlaczego jedni mogą korzystać z tego rozwiązania, a inni nie…? Ale nie o to tu teraz chodzi i pozostawiam to innej ocenie.

Nie chce uchodzić za dostępnościowego dżihadżystę, ale jeśli mamy otrzymywać takie rewelacje podobne do tych jakie serwuje mi platforma Teams ze swoim automatycznym tłumaczeniem, to lepiej niech to rozwiązanie nie będzie w ogóle dostępne lub przynajmniej wyłączone dla języka, z którym sobie nie radzi.

A dla znających język angielski i chcących zobaczyć i posłuchać kilka rewelacji związanych z asystentami głosowymi polecam obejrzeć filmy z cyklu:

Si nigdy nie zastąpi człowieka w testowaniu dostępności.

Jak już jesteśmy przy nowoczesnych technologiach, kiedy mówi się o postępie w opracowaniu AI itd., mówi się o rozwiązaniach, które potrafią świetnie rozpoznawać obiekty czy osoby na zdjęciach i je odpowiednio opisywać/tagować lub komunikować o nich. Wszystko po to, aby ostrzec użytkownika o czymś, skrócić czas dotarcia do informacji lub dać poprawny kontent osobie niepełnosprawnej. Jak już wykazałem wcześniej, różnie z tym bywa, ale nawet jeśli będzie to robione poprawnie to jest to zaledwie ułamek wymagań dotyczących dostępności, których SI jest w stanie spełnić.

Wiele wymagań dostępności jesteśmy w stanie zweryfikować automatem, ale wciąż większość z nich wymaga i będzie wymagać weryfikacji manualnej. Ma to w szczególności ogromne znaczenie, dla tłumaczeń i różnego rodzaju „trudnych” do zrozumienia/nauczenia się języków jak chiński, polski, węgierski, czeski czy arabski, jak również wielu nie zerojedynkowych przypadków oceny dostępności np. widoczności fokusa czy odpowiedniego uporządkowania elementów na stronie. Tego się nie da po prostu zastąpić SI, a nawet jeśli się to pociągnie to za sobą astronomiczne koszty. Skórka nie warta wyprawki.

AI jest często omylna

O tym, że AI bywa często zawodna, przekonałem się testując jedno z rozwiązań oparte na mechanizmie OpenAI o nazwie Whisper. Zachęcony rekomendacją jednego z polskich ekspertów od dostępności poczytałem o tym rozwiązaniu, przetestowałem i… jak nie miałem, tak nadal nie mam do AI przekonania. Sprawa dość prosta. Postanowiłem wygenerować polskie napisy do trzyminutowego filmu na temat SavoirVivre wobec niepełnosprawnych wydanego przez rząd brytyjski.

Jaki był tego wynik?

Nie dość, że musiałem pobrać kilka gigabajtów danych słownika uczącego dla narzędzia, co trwało kilka dobrych minut, sam 3 minowy film "tłumaczył się" ponad 5 min, to na koniec wypluł takie kwiatki, że głowa mała.

Po angielsku: 'people with dissabilities' to po naszemu 'osoby z dyspilityzacją'. Normalnie nowomowa, gdyż takiego słowa nie ma nawet w języku PWN.

'One easy way to focus on the person is to watch the person signing' to na język Polski 'Jedną prostą drogą, by skupić się na osobie, jest to, żeby patrzeć na sygnał'. Jaki sygnał, tego nie wiem?

Słowo towarzysz (z ang. companion) w ogóle nie zostało przetłumaczone.

'zróbmy z poprosem', nawet nie wiem co to znaczy...

'Jeśli chcesz mi pomóc, pozwól mi przytrzymać się twojego ołowca' - pozostawiam bez komentarza :)

Podsumowując

Nie chcąc iść na wojnę z rozwiązaniami SI muszę przyznać, że robimy coraz większe postępy w tej dziedzinie, ale niestety to czynnik ludzki póki co jest i przez dłuższy czas będzie najlepszym sposobem weryfikacji dostępnych rozwiązań. Si jeszcze raczkuje w tej materii. Oczywiście uczenie maszynowe czy sztuczna inteligencja choć są świetnymi rozwiązaniami wspierającym osoby niepełnosprawne, to nie łudźmy się one nigdy nie rozwiążą do końca problemów osób niepełnosprawnych.

Obecne rezultaty wygenerowane przez AI są obarczone zbyt dużą ilością błędów i tzw. halucynacjami, które jak mogliście zauważyć w przypadku tłumaczeń czy tekstów alternatywnych, mogą wprowadzić użytkownika w błąd.

Ponad to algorytmy SI często robią coś wprost i nadmiarowo, np. sztucznie dodając treści alternatywne to elementów dekoracyjnych, które tego nie potrzebują.

Póki co algorytmy SI nie uwzględniają takich lub im podobnych reguł. Wiec wymagają one re-ewaluacji i przepisania.

Obecne narzędzia i funkcje na przykład do automatycznego tworzenia napisów nie są jeszcze tak dokładne, jak osoby tworzące transkrypcje manualnie, a tekst alternatywny dla obrazów generowany automatycznie często nie jest adekwatny do treści na obrazie.

Dla lekkiej osłody dodam, że paru specjalistów dziedzinowych np. osoby z komitetu W3C czy Międzynarodowego Stowarzyszenia Specjalistów ds. Dostępności (IAAP) jest zdania, ze SI jest nie jest zła i drzemie w niej duży potencjał w kwestii zapewniania dostępności, jednak należy wdrażać ją ostrożnie.

No cóż, mam nadzieję, że rzeczy o których wspomniałem będą się zmieniać na lepsze, ale na razie w żaden sposób nie zastąpią testów dostępności skoncentrowanych na człowieku, a na pewno nie wyeliminują go z tego procesu.

Tymczasem ja idę "odżywiać lody" i "poić rosliny", jak na człowieka przystało.

- https://www.automaticsync.com/captionsync/youtube-automatic-captions/

- American with Disability Act

- https://www.widzialni.org/container/Dostepne-multimedia.pdf

- https://knowyourmeme.com/memes/youtube-automatic-caption-fail/

- https://www.rev.com/blog/caption-blog/funny-closed-caption-fails

- https://www.youtube.com/watch?v=qlQJZ_mU8B0